腾讯于2025年5月28日正式发布并开源了语音驱动数字人模型 HunyuanVideo-Avatar,该模型由腾讯混元视频大模型(HunyuanVideo)与腾讯音乐天琴实验室的 MuseV 技术联合研发,旨在通过简单的输入,实现高保真、多角色、情绪可控的虚拟人视频生成。

核心功能与技术亮点

- 输入即生成:用户只需上传一张人物图像和一段音频,模型即可自动理解图像中的人物环境信息及音频所蕴含的情感,使图中人物自然地说话或唱歌,生成包含自然表情、唇形同步及全身动作的视频 。

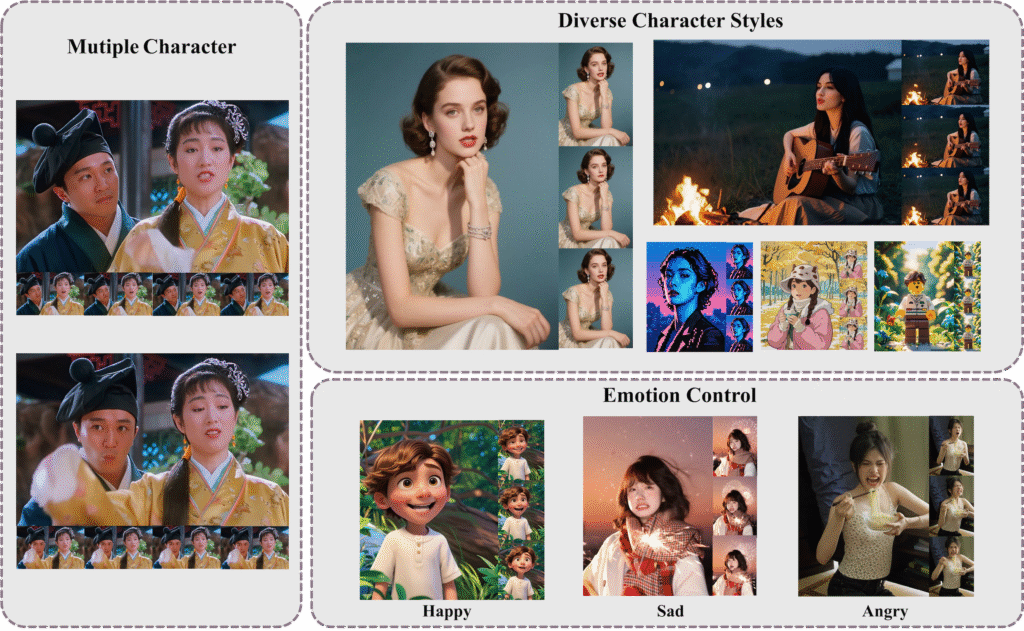

- 多样化风格与场景支持:支持头肩、半身与全身景别,以及多风格(如照片级写实、卡通、3D 渲染和拟人化角色)、多物种与双人场景,面向视频创作者提供高一致性、高动态性的视频生成能力 。

- 先进的多模态架构:采用多模态扩散 Transformer(MM-DiT)架构,具备强大的多模态理解能力,能够自动识别输入图像中的人物环境信息以及音频所蕴含的情感,实现高动态、情绪可控和多角色对话视频的生成 。

关键技术创新

- 1角色图像注入模块:替代传统的加法式角色条件方案,消除训练与推理阶段的条件不匹配问题,确保动态动作与角色一致性。

- 2音频情感模块(AEM):从情感参考图像中提取并转移情感线索到目标生成视频,实现细粒度且准确的情绪风格控制。

- 3面部感知音频适配器(FAA):通过潜在层级的面部掩码隔离音频驱动角色,实现多角色场景下的独立音频注入。

这些创新使 HunyuanVideo-Avatar 在基准数据集和新提出的野外数据集上超越了现有的最先进方法,生成了逼真的虚拟人动画 。

应用场景

- 短视频创作:快速生成具有自然表情和唇形同步的虚拟人视频,适用于社交媒体内容制作。

- 电商与广告:生成产品介绍视频或多人互动广告,降低制作成本,提高内容吸引力。

- 在线直播与教育:创建虚拟主播或讲解员,提升互动性和观众参与感。

获取与体验

- 开源平台:HunyuanVideo-Avatar 的单主体能力已在腾讯混元官网上线,用户可以在“模型广场-混元生视频-数字人-语音驱动-HunyuanVideo-Avatar”中体验,目前支持上传不超过14秒的音频进行视频生成 。

- 代码与模型下载:相关代码和模型已在 GitHub 和 Hugging Face 平台开源,供开发者和研究者使用。

发表回复